| 구 분 | 내 용 | 지원 규모 |

|---|---|---|

| 데이터 혁신활용 (HDR) |

▪ 데이터 과학자 및 엔지니어, 시스템 및 사이버 인프라 전문가로 구성된 연구소 발족(Data Science Corps., DSC)지원 - 데이터 과학 프로젝트 강의 및 실습 지원 - 참여 학생의 급여 지원 ▪ 과학 및 공학 데이터 집중연구 프레임 워크 구축 |

▪ 3년 $100~150만 (사업에 따라 다름) |

| 인간-기술 프론티어 미래직업 (FW-HTF) |

▪ AI로 인해 변화하는 일자리 환경에 대한 도전 및 기회에 대응하는 것을 목표 - 인간인지 강화를 위한 기초 연구 - 구체화된 지능형 인지보조 연구 ▪ 미래의 작업에 대한 근본적인 이해를 높이고, 작업 및 작업장, 근로자와 사회의 작업 결과에 대한 잠재적 개선 방안 도출 - 인간-기술 파트너십에 대한 이해와 개발 - 인적 성과를 높이기 위한 기술의 설계 ▪ 신규 AI 관련 사회-기술 융합의 발굴 및 기술의 이점과 위험을 파악 |

▪ 소규모(3~5년) $75~150만 ▪ 대규모(3~5년) $150~300만 |

| 세부 주제 | 내 용 |

|---|---|

| 새로운 기능 (New Capabilities) |

▪ 정교한 사이버 공격에 대한 실시간 분석, 가짜 이미지 감지, 자연어 기술, 자동 다중 타겟 인식, 생체의학적 보철신체의 제어, 역동적 전투 킬체인 등 |

| 강력한 AI (Robust AI) |

▪ 공간기반의 이미지 분석, 사이버공격 경고, 미생물 시스템의 공급망 분석, 안정적인 성능 보장 |

| 적대적 AI (Adversarial AI) |

▪ 머신러닝이 잘못된 학습데이터에 의해 오염되지 않도록 안정성을 보장 |

| 고성능 AI (High Performance AI) |

▪ 더 낮은 전력소모로 향상된 성능을 보이는 고효율 AI 개발(1000배 빠른 속도와 1000배 향상된 전력효율) |

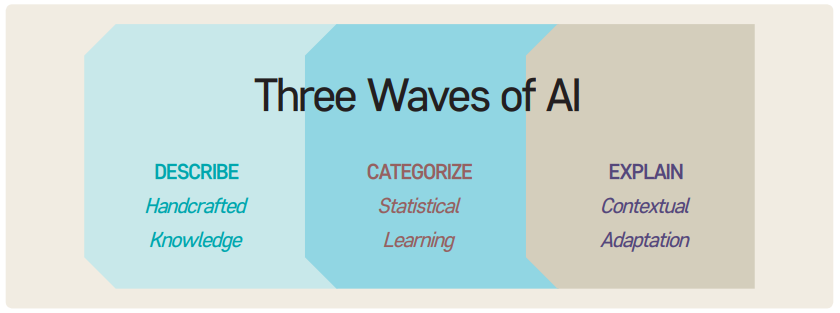

| 차세대 AI (Next Generation AI) |

▪ AI 시스템이 맥락을 이해하고, 행동을 설명하고 상식적으로 추론할 수 있도록 하는 것을 목표 |

| 세부 분야 | 연구주제 | |

|---|---|---|

| 단기 | 장기 | |

| AI에 의한 법적 추론 및 의사결정 | ▪ AI는 현재 변호사보다 더 빠르고 정확하게 판례를 찾을 수 있는데(NIST 연구로 판명), 이러한 AI 시스템의 법적 업무 수행에 있어서 윤리적이고 전문적인 의미는 무엇인가? | ▪ 어떻게 법률 시스템에 AI를 통합 할 것인가? ▪ 인간보다 더 빠르고 정확한(공정한) AI판사에 대해 사회가 어떻게 대응할 것인가? ▪ 인간보다 우월한 AI변호사에게 법적 작업을 위임하는 것은 적절한가? |

| 사실자료 찾기와 개인 사생활 보호 간의 균형 | ▪ 휴대폰, 웨어러블 기기 등 개인 디바이스의 증가 및 IoT의 발달로 점점 더 많이 수집되는 개인 정보를 법적으로 활용할것인가? 한다면 어떻게 활용할 것인가? | ▪ AI와 인간의 지능이 융합된다면, AI로 향상된 지적·논리적 능력 및 생체리듬·감정상태·꿈 등의 기록과 추적에 있어서 어떻게 개인 정보 보호와 인간 존엄성을 묘사할 것인가? ▪ 법적 분쟁 시 사실에 근거한 판결문과 인간의 존엄성 사이에서 어디에 선을 그을 것인가? |

| 인간지능(HI)과 인공지능(AI)간 유무죄 판단 | ▪ 인간-컴퓨터 간의 상호작용(HCI)에 있어서 이미 다양한 분야(건강, 항공, 데이터 분석 등)에서 발생할 수 있는 오류의 책임 문제 | ▪ 인간의 정신능력이 나노컴퓨터에 의해 보완된다면, 여기서 발생하는 죄책감과 같은 감정이나 범죄행위 등의 유무죄 판단은 어떻게 할 수 있는가? 누가 책임져야 하는가? |

| 정의에 대한 접근 보장 | ▪ 소송에 있어 더 많은 근거자료를 찾는 일은 결국 노력과 자금과 시간이 들어가는 비용이며, 이러한 비용지불 능력의 유무에 따라 소송의 승패가 갈리는 문제를 AI가 해결하는 현상 | ▪ 엄청나게 발생할 인간·인공지능 데이터를 어떻게 통제할 것인가? ▪ 수많은 데이터를 통해 정확하고 신속하며 비용이 별로 들지 않는 판단을 어떻게 할 것인가? ▪ 법적인 문제 해결을 점점 AI에 의존하게 되면, 인간의 정의가 오히려 불편해지는 시기가 오지 않을까? |

| 법률 및 규정 시행 | ▪ 도시 곳곳에 비치된 감시카메라, 차량에 설치된 GPS 등으로부터 실시간으로 수집되는 각종 데이터를 기반으로 앞으로의 상황을 예측하고 대응하기 위한 AI의 활용 | ▪ 공공장소에서 얼굴을 인식하고, 행동을 녹화하며, 수많은 IoT 장치들로부터 개인의 활동 정보를 수집하는 AI가 속도위반 시 벌금 경고를 핸드폰으로 알려주는 등과 같은 서비스를 제공한다고 할 때, 이러한 서비스는 독재적이고 중앙 통제적인 사회를 만드는 것은 아닌가? |

| 세부 분야 | 연구주제 | |

|---|---|---|

| 인공지능과 뇌 그리고 | 윤리 | ▪ 인간의 마음을 복제하는 능력의 발전에 따라 기계가 인간처럼 복잡한 감정을 흉내낸다면 기계에게 권리를 부여해야 하는가? 그들은 인간이 될 수 있는가? 이를 대비하기 위해 어떤 정책을 세워야하는가? |

| 데이터 | ▪ 머신러닝에 의해 발견되지 않는 패턴의 데이터는 어떻게 책임감 있게 처리하며 개인 정보에 대한 보호를 할 것인가? ▪ 어떻게 하면 인공지능이 인간의 뇌에서처럼 신경화학적인 편향성을 보이지 않고 더 도적적인 판단을 하도록 할 것인가? ▪ 인간의 의식이 더 정교할 수 있는 AI에게 어떻게 도움이 될 수 있는가? ▪ 이를 개발하고 통제하는 조직(공공 또는 민간)의 역할은 무엇인가? |

|

| 살아있는 것 | ▪ 우리 자신과 유사한 인공지능을 연구하기 위해 애니맷(Animat)과 하이브롯(Hybrots)을 제작하며 관찰하는 연구 - 애니맷 : 인공적으로 만든 로봇 동물 - 하이브롯 : 하이브리드 로봇으로 전자요소와 생물요소가 합쳐져 컴퓨터로 제어되는 로봇형태의 사이버네틱 유기체 |

|

| 노동 | ▪ AI의 성능이 갈수록 정교해짐에 따라 높은 수준의 사무직도 대체할 수 있는 잠재력이 있으며, 앞으로 어떻게 대응해야 하는가? 어떤 정책이 필요한가? | |

| 세부 분야 | 연구주제 |

|---|---|

| 데이터 수집 | ▪ 개인정보에 해당하는 인간 건강 데이터에 대한 기술뿐만 아니라 윤리 및 법적 사항에 대한 고려 ▪ 데이터에 대한 품질, 무결성, 거버넌스 및 보안에 대한 고려 ▪ 전자의무기록(EHR) 및 개인웨어러블 헬스기기 간의 데이터 통합 문제 ▪ 환자에게 의료서비스를 제공하기 위해 수집된 의료데이터의 활용 및 야기되는 수익에 대한 윤리성 ▪ 본래의 의도를 벗어난 목적의 의료데이터 활용에 대한 규제 ▪ 데이터의 소유권과 접근권한 문제(EHR 제공업체와 의료기관 간의 파트너십과 시장경쟁력에 실질적 영향을 미치는 상황에 대한 고려) |

| 지식 습득 및 표현 | ▪ 인류의 의료기술은 과거에 비해 무척 발달했지만, 아직 많은 밝혀지지 않은 영역에 대한 해결 가능성 ▪ AIM에 의해 생성되는 의료지식에 대한 온톨로지(Ontology)14 보장 문제 |

| 설명 | ▪ AI가 내린 결론 및 결론을 내리는 방법에 대한 이해의 문제 ▪ 설명 가능한 AI와 임상용으로 AIM 시스템에 대한 검증과 승인 문제 |

| 헬스 시스템 통합 | ▪ AI가 어떻게 기존의 임상시험 절차와 인력을 변화시킬 것인가? 기존의 의료계는 이를 받아들일 것인가? ▪ 의사보다 더 뛰어난 AIM의 기술적인 분석 결과를 의사가 채택할 수 있는가? ▪ 신뢰가 중요한 의학 분야에서 AI에 대한 신뢰문제는 어떻게 해결할 것인가? 높은 수준의 AI 안전성과 실무 임상의의 AI에 대한 우려 사이의 간극은 어떻게 좁힐 것인가? |

| 세부 분야 | 연구주제 |

|---|---|

| 인간 영향 (Human Impact) |

▪ 공정하고 신뢰할 수 있는 AI 개발을 위해 AI의 수행방식을 이해하고, AI가 인간, 사회구조 및 기관, 국제질서와 상호작용하는 체계 수립 연구 - AI가 보편화됨에 따른 오해와 사회적 직면 문제의 해결 |

| 인간 역량 강화 (Augment Human Capabilities) |

▪ AI 에이전트 및 응용프로그램이 사람들과 보다 효과적으로 의사소통하며 협업·보강할 수 있도록 하는 연구 - 인간의 의사결정과 다양한 작업에 대한 품질 향상을 도와 줄 수 있는 진보된 AI |

| 지능 (Intelligence) |

▪ 궁극적으로 인간의 언어와 감정, 의도, 행동, 다양한 규모의 상호작용을 이해하는 AI의 개발과 접근법 - 차세대 인간 중심의 AI를 개발하기 위한 신경·인지 과학적 접근법 |

| 구분 | 내 용 | |

|---|---|---|

| AI의 윤리와 거버넌스 연구그룹 | ▪ AI 윤리 및 거버넌스에 대한 증거자료 기반의 연구 수행 및 제안 - 제도적 지식기반 구축 - 인적자원 육성 - 산업 및 정책 입안자와의 인터페이스 강화 |

|

| AI 시대의 알고리즘적의사결정과 거버넌스 | ▪ 사회의 의사결정 프로세스에 AI를 활용하고, 이에 필요한 윤리적인 지침과 모범사례 연구 ▪ AI의 의사결정 맥락에 차별적 요소를 분류하고 응용하는 연구 - 위험지수 예측에 따른 건물 검사와 형사적 선고를 내리는 것은 동일한 알고리즘적 의사결정이 아님 ▪ 전 세계 AI정책 입안자와 실무자가 AI 전략과 정책, 윤리와 거버넌스에 관한 올바른 결정을 내릴 수 있도록 참조모델을 제공하는 연구 |

|

| 순환적 사회 | ▪ 인간-기계 간 사회시스템을 위해 필요한 새로운 거버넌스 아키텍쳐 설계 - 정치철학과 문화인류학을 반영한 거버넌스 연구 |

|

| AI와 포용 | ▪ 사회의 다양성과 포용성을 지원하기 위한 AI 시스템 설계 및 배포 방법 연구 - 연령, 민족성, 인종, 성별, 종교, 출신국가, 위치, 기술과 교육수준, 사회경제적 상태의 기준에서 소외계층에 대한 AI 연구 |

|

| AI와 글로벌 거버넌스 | ▪ AI 관련 기술의 국가 간 영향을 고려하여 세계적으로 운영될 수 있는 적절하고 실행 가능한 거버넌스 매커니즘 연구 - 미국, 유럽, 아시아에 걸친 사례연구 및 실무회의를 통해 모델 수립 |

|

| 법률에서 인간다운 AI | ▪ AI의 발전에 따라 AI의 의사결정에 대해 감시하고 개선하기 위한 적법절차 프레임워크를 확립하는 연구 및 이를 위한 기술·법적 기반의 구축 - 판사의 형사적 판결을 돕는 도구로써 AI 시스템의 개선 |

|

| 로봇과 AI의 사회적 영향 조사 | ▪ 로봇과 AI가 일상생활에 미치는 영향을 탐색하는 도구 개발 - 지능형 에이전트와 개인 간의 상호작용을 기록하고 디자인에 반영하는 연구 |

|

| 소셜 로봇 연구 (사회적 지능을 갖춘 AI) |

▪ 상호 대화에서 상대방의 반응을 살피고 주의를 끌 수 있는 대화기법을 가진 AI 연구 - 실시간 인식 및 행동 생성이 가능한 소셜 로봇을 제어하는 AI 알고리즘 개발 |

|

| 의약 및 치료 임상실험을 위한 AI 개발 연구 | ▪ 윤리적이고 안전하며 설명 가능한 AI 기반의 약품 및 치료 임상실험 개발 - 광범위한 환자 기반의 임상실험을 디지털로 대체하며 실험 비용 절감과 조기 시장 진출로 치료의 신속성을 보장하는 연구 |

|

| 세부 주제 | 내 용 |

|---|---|

| 인공지능과 정의 (AI and Justice) |

▪ 공공행정에서 자율성(Autonomy - AI에 의한 판단)을 채택하고 유지하는 것에 있어서 고려할 법적, 제도적인 사항은 무엇인가? ▪ 형사사건의 판단에 있어서 인과관계 모델 같은 자율성의 역할을 재정립 하는 것(AI가 형사적 판단을 할 경우 판단 범위와 방법) |

| 정보 품질 (Information Quality) |

▪ 머신러닝과 자율시스템이 공공영역에 미치는 영향력 ▪ AI 플랫폼과 대국민 간 효과적인 거버넌스와 공동개발 구조에 대한 연구 ▪ AI의 경험(학습)기반 시스템이 잘못된 정보를 학습할 경우에 대한 정책적 대응 방안 |

| 자율화와 상호작용 (Autonomy and Interaction) |

▪ 자율 시스템과 대중 간의 상호작용에 있어서 도덕적이고 윤리적인 측면에 대한 연구 ▪ 인간의 직관이 어떻게 시스템에 잘 통합될 수 있는지에 대한 연구 ▪ 시스템의 디자인과 사람-컴퓨터 간 인터페이스(HCI)의 효율적인 제어 및 명령 해석에 대한 연구 |