| 예측결과 기반 |

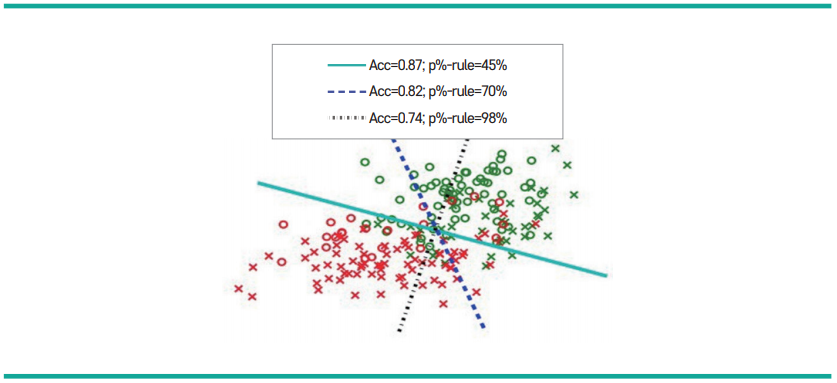

그룹 공정성 (통계적 동등성, 동등한 승인율) |

그룹별로 긍정적 예측값을 할당받을 확률이 동일 |

| 조건부 통계적 동등성 |

특정 데이터 속성(요소)을 통제했을 경우 그룹 별로 긍정적 예측값을 할당받을 확률이 동일 |

| 예측·실제결과 기반 |

예측적 동등성 결과 동등성 |

그룹별로 긍정적 예측값의 비율이 실제로 동일해야 함 |

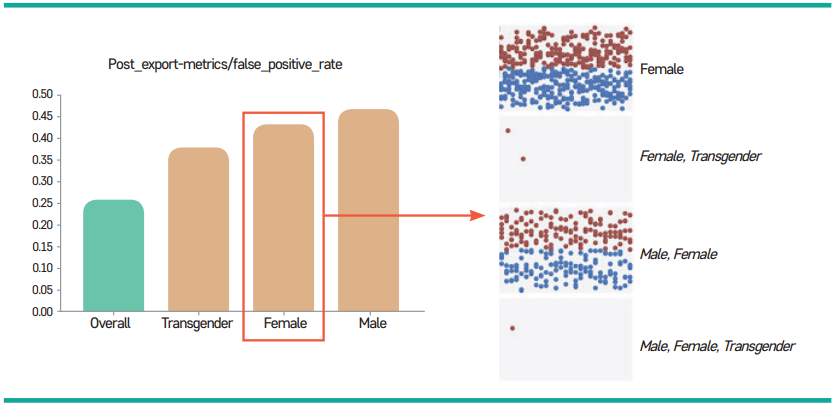

| 위양성율(Type I Error/ False Positive Error Rate) 균형 |

그룹별로 위양성 예측값을 할당받을 확률이 동일 |

| 위음성율(Type II Error/ False Negative Error Rate) 균형 |

그룹별로 위음성 예측값을 할당받을 확률이 동일 |

| 동등확률 |

그룹별로 실제 값 기반 진양성율(TPR, True Positive Rate)과 위양성율(FPR, False Positive Rate)은 동일 |

| 조건부 사용 |

정확도 동등성 그룹별로 예측 값 기반 양성예측도(PPV, Positive Predictive Value)와 음성예측도(NPV, Negative Predictive Value)가 동일 |

| 전체 정확도 동등성 |

그룹별로 전체적인 예측 정확도(진양성: True Positive, 진음성: True Negative)가 동일 |

| 치료 동등성 |

그붑별로 위양성(False Positive)과 위음성(False Negative)의 비율이 동일 |